搭建jupyter notebook

安装python3

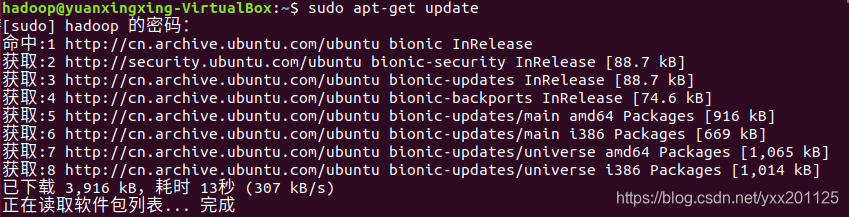

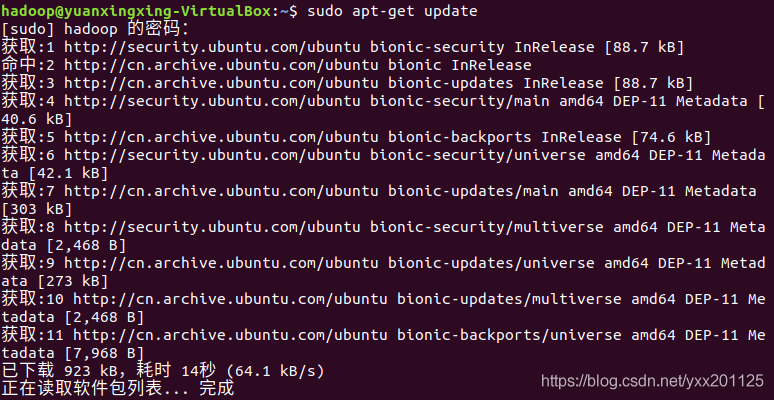

更新软件包

1 | sudo apt-get update |

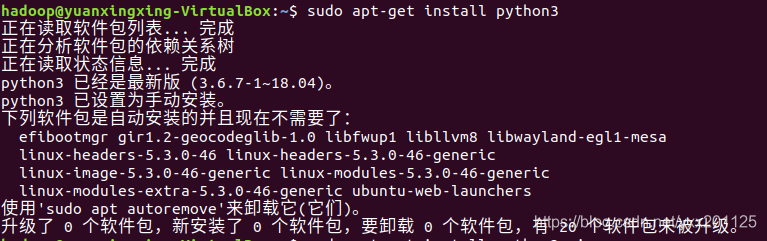

安装 python3,默认 python3 将安装最新版本,一般Ubuntu都自带python在 /usr/local目录下

1 | sudo apt-get install python3 |

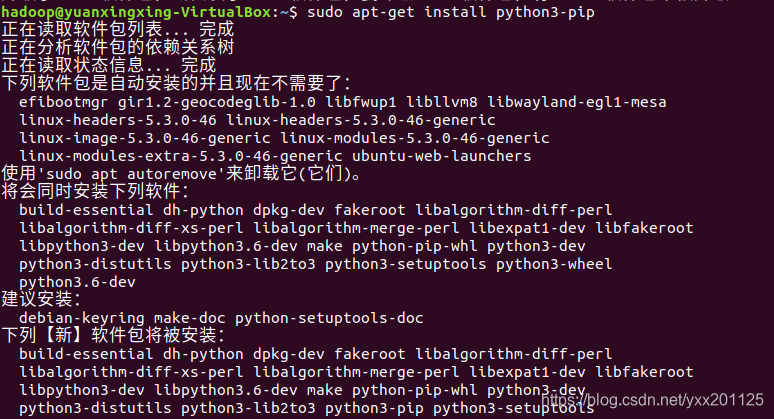

安装python第三方安装工具:

1 | sudo apt-get install python3-pip |

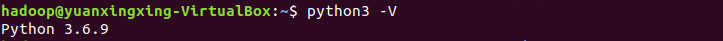

查看python3版本信息

1 | python3 -V |

安装jupyter notebook

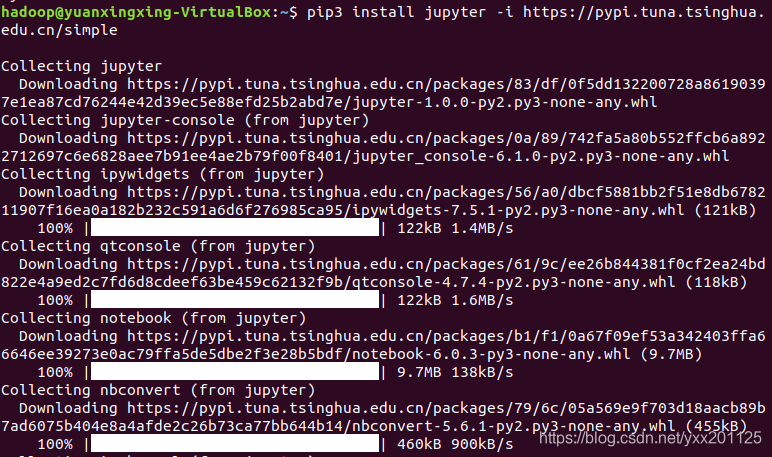

下载jupyter notebook

1 | pip3 install jupyter -i https://pypi.tuna.tsinghua.edu.cn/simple |

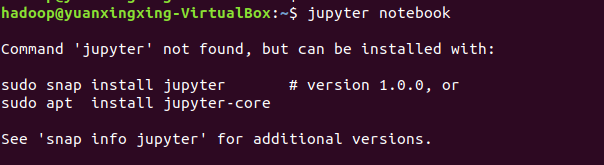

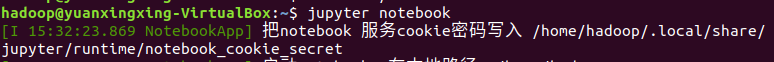

运行 jupyter notebook

1 | jupyter notebook |

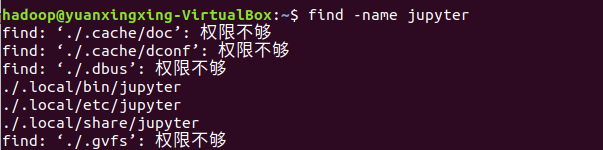

使用find命令找出 jupyter

1 | find -name jupyter |

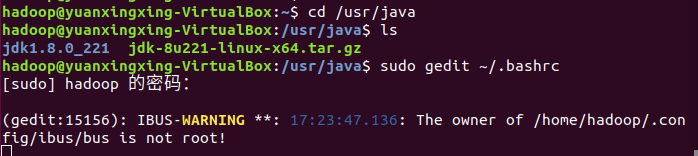

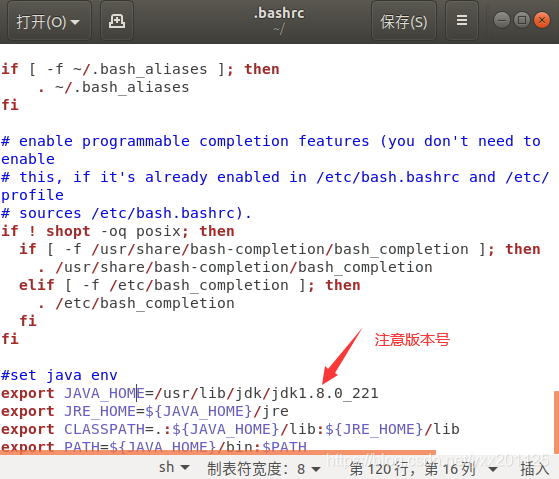

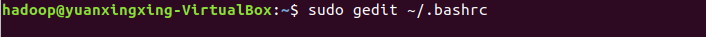

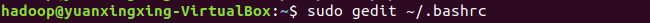

将上述路径添加到环境变件中

1 | sudo gedit ~/.bashrc |

1 | export PATH=~/.local/bin:${PATH} |

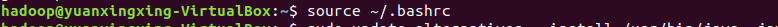

使环境变量生效

1 | source ~/.bashrc |

运行 jupyter notebook

1 | jupyter notebook |

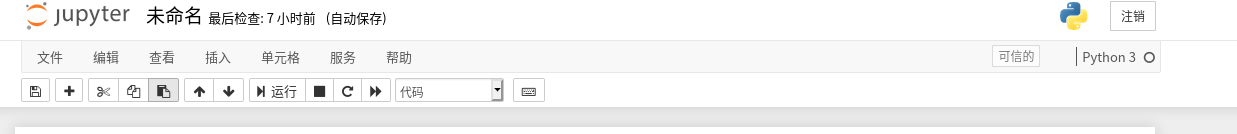

Jupyter Notebook是基于网页的用于交互计算的应用程序。可以直接在网页上新建文件进行编写

jupyter与spark的链接

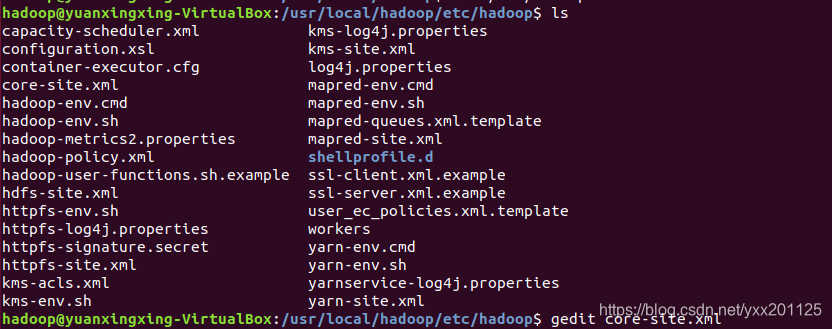

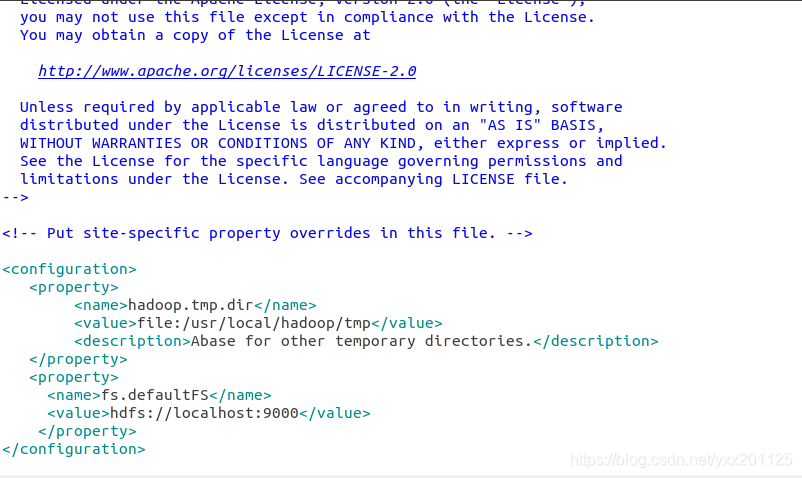

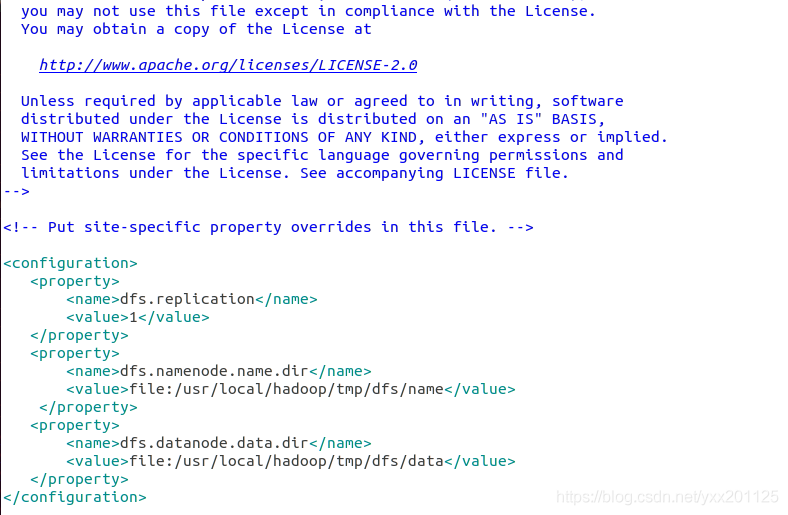

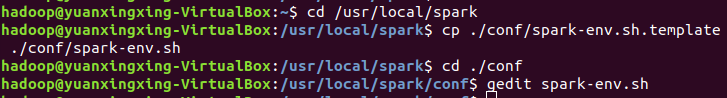

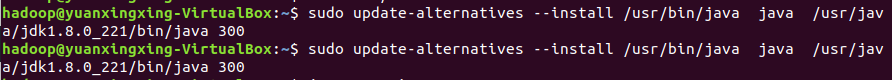

修改配置文件

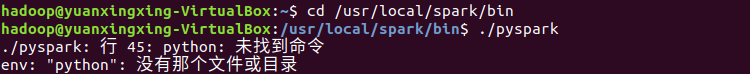

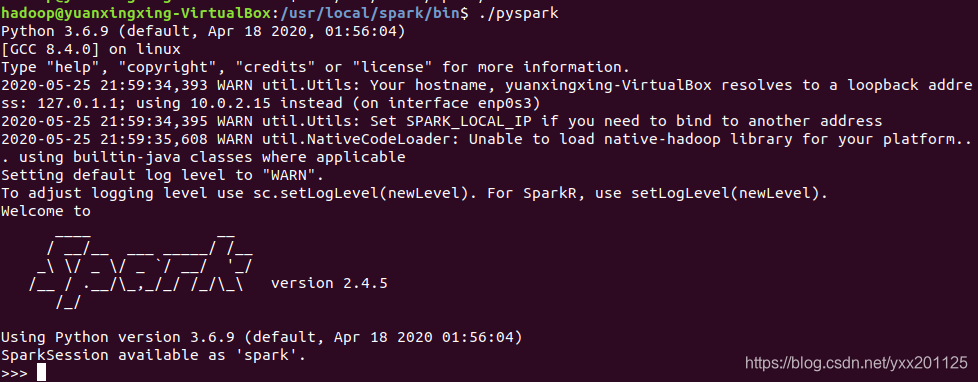

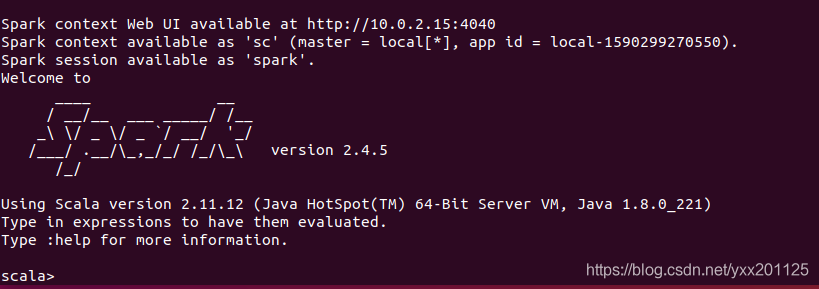

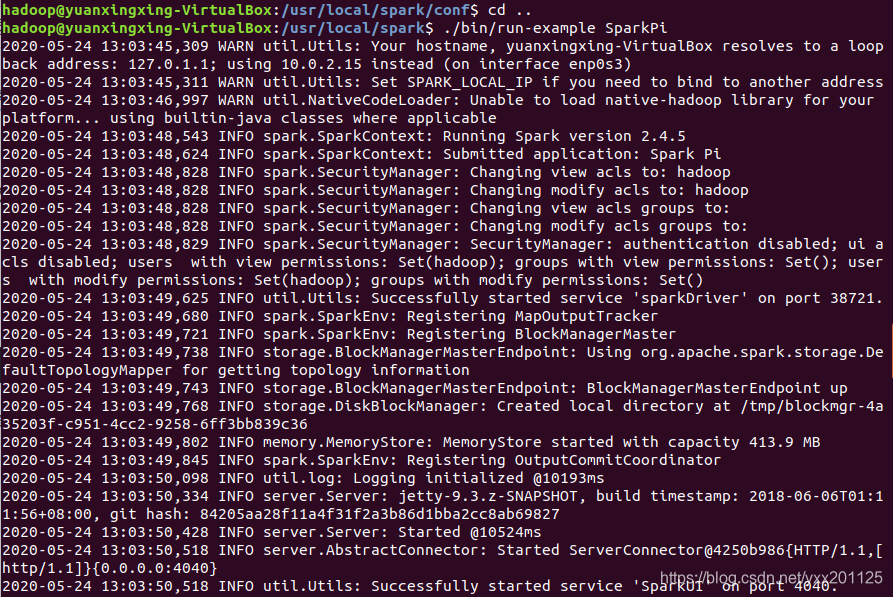

运行pyspark

1 | cd /usr/local/spark/bin |

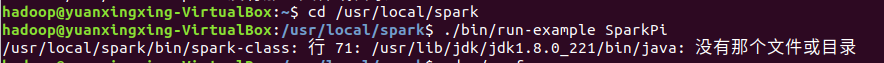

直接运行pyspark可能会出现以下错误:

因为没有配置Spark python的环境变量

1 | pyspark:行 45: python: 未找到命令 |

解决办法:

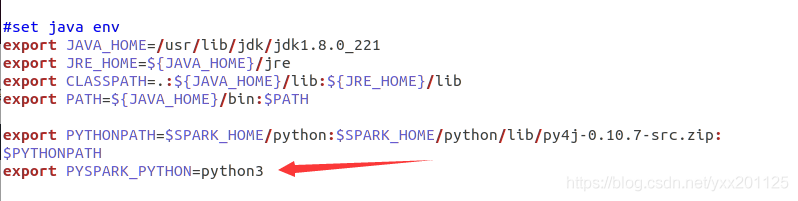

添加python相关环境变量

1 | gedit ~/.bashrc |

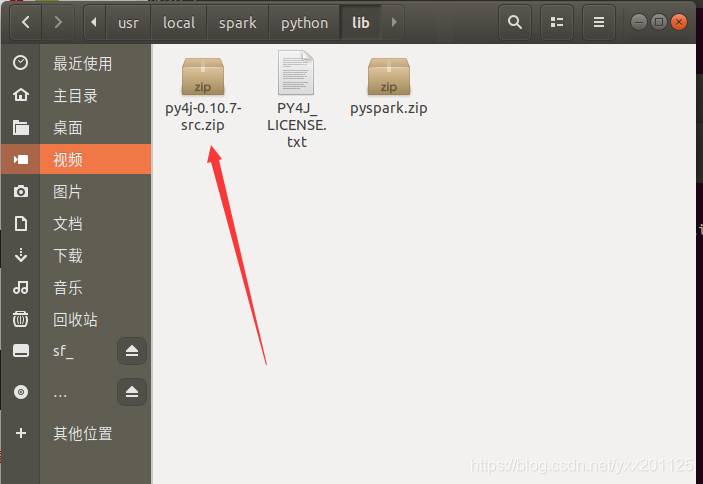

1 | export PYTHONPATH=$SPARK_HOME/python:$SPARK_HOME/python/lib/py4j-0.10.7-src.zip:$PYTHONPATH |

注意:py4j-0.10.7-src.zip要到/usr/local/spark/python/lib目录查看是否是这个名称。不同版本的py4j的名称会有差别。

保存后,让环境变量生效

1 | source ~/.bashrc |

再次运行pyspark

1 | ./pyspark |

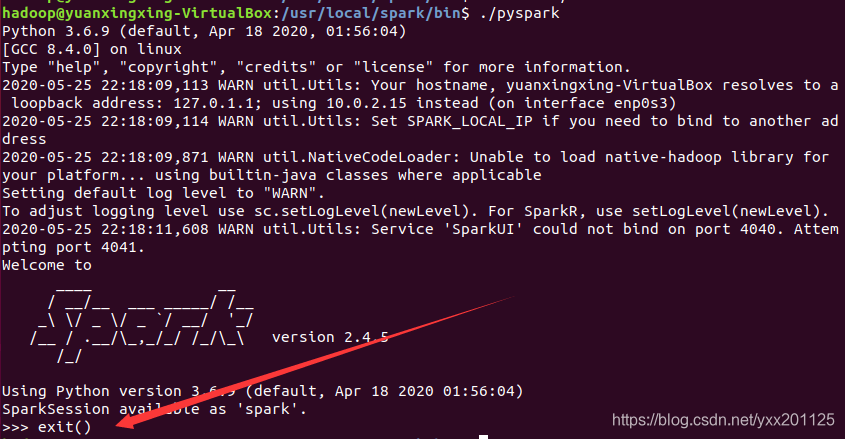

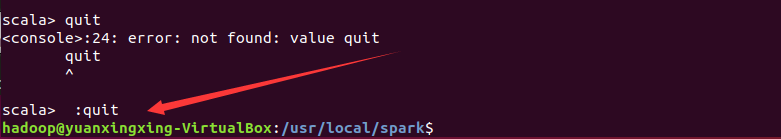

退出pyspark

退出pyspark

1 | exit() |

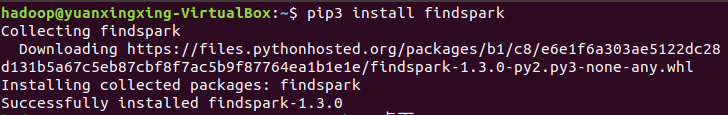

链接jupyter与spark

安装 findspark

1 | pip3 install findspark |

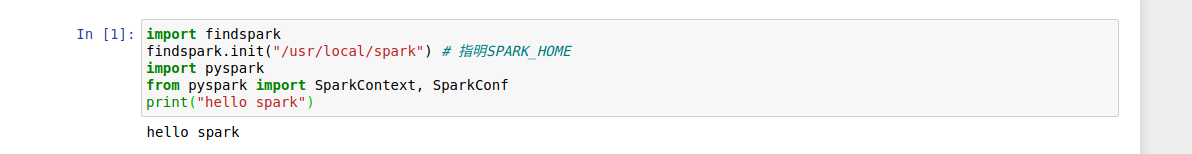

测试 jupyter 是否成功连接 spark

1 | import findspark |

成功链接,则会输出 “hello spark”

至此,ubuntu搭建jupyter notebook以及jupyter与spark的链接就结束了,如果博客中有问题,欢迎各位大神们指点迷津

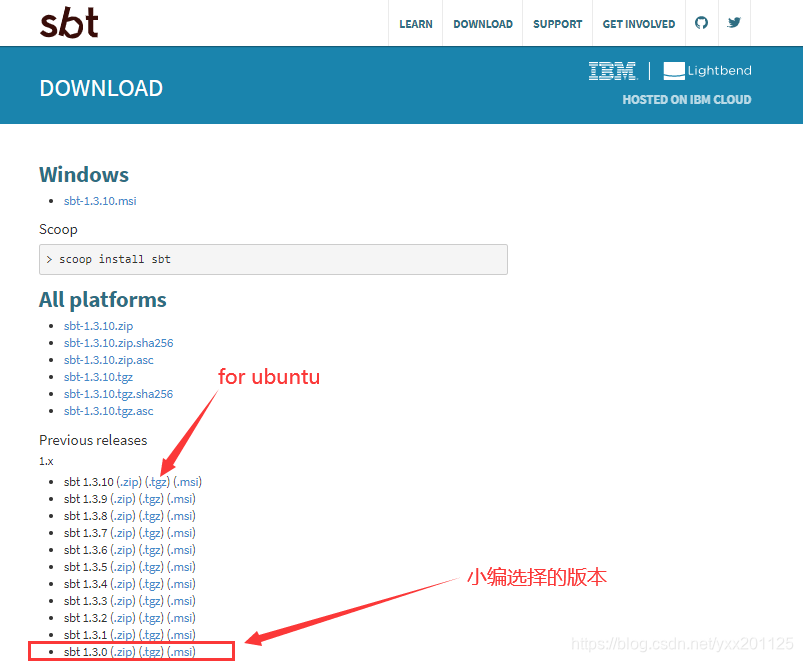

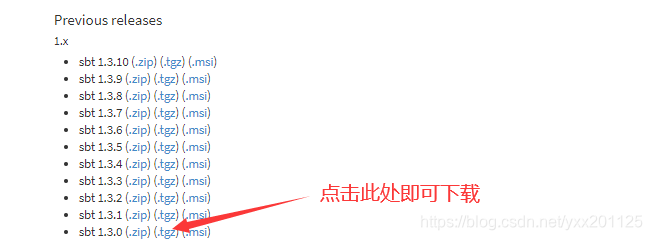

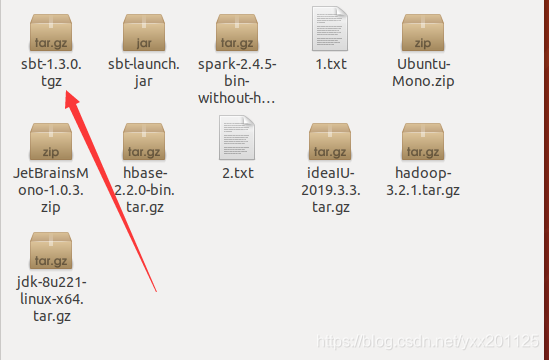

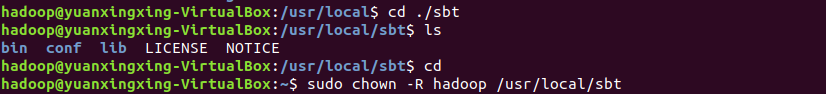

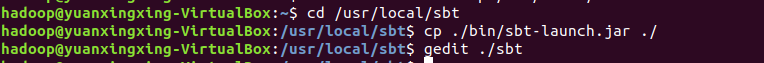

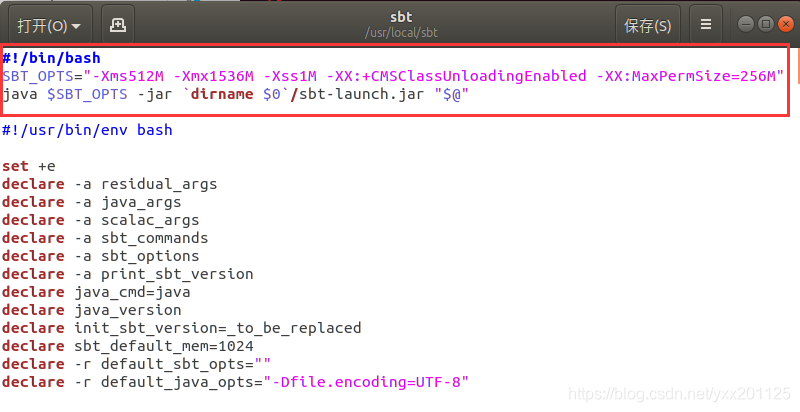

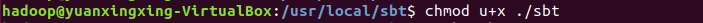

为sbt脚本文件增加可以执行权限

为sbt脚本文件增加可以执行权限

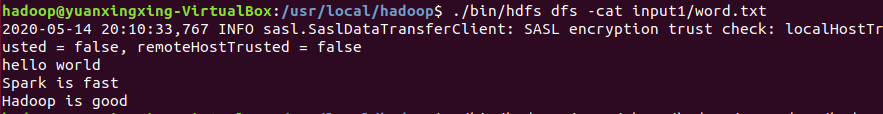

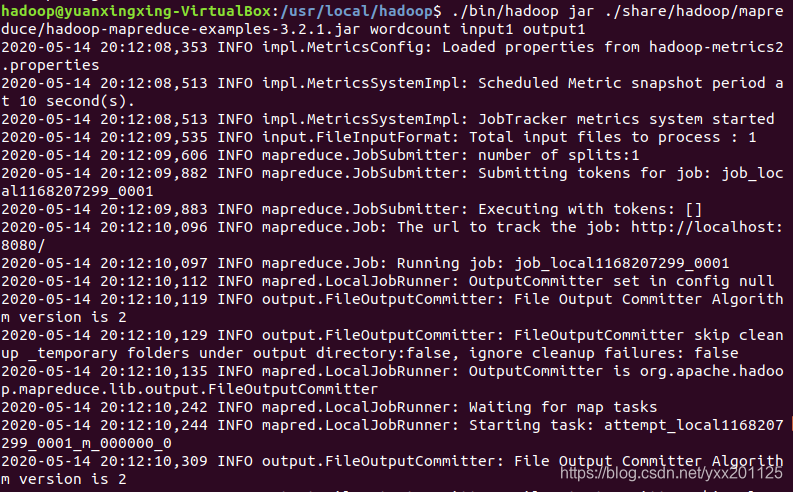

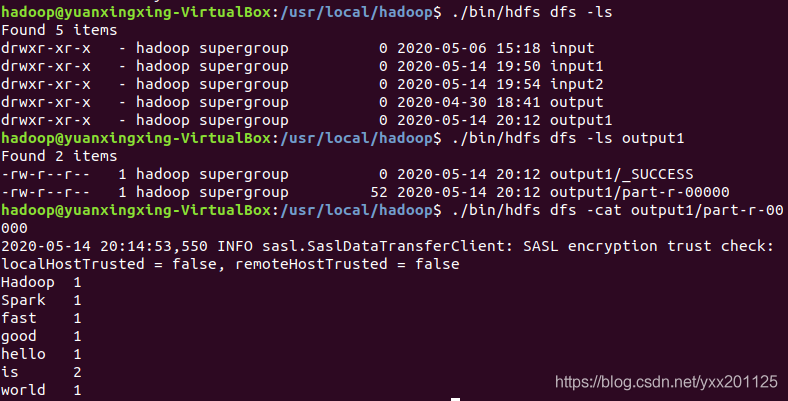

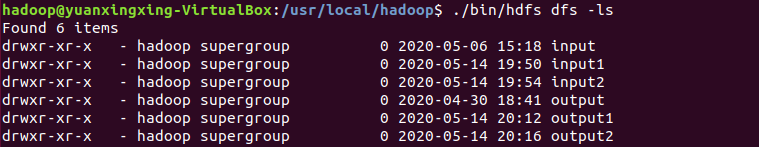

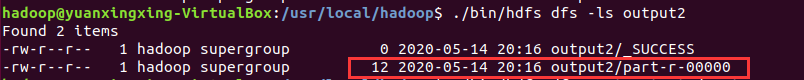

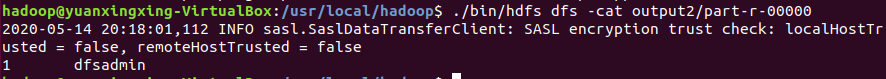

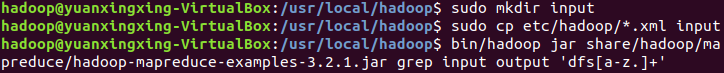

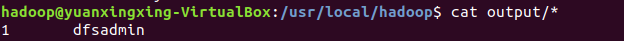

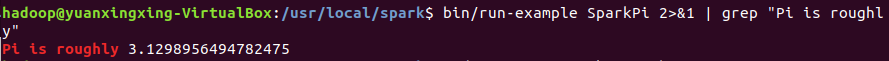

3.查看相应的计算结果

3.查看相应的计算结果