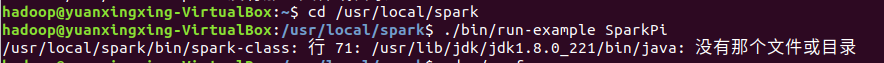

报错情况如下

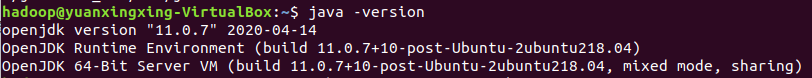

测试java是否安装成功

1 | java -version |

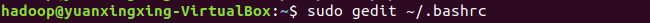

检查java配置文件是否正确

1 | sudo gedit ~/.bashrc |

检查该文件中对应的java路径是否正确

1 | #set java env |

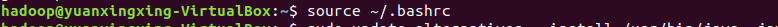

若不正确,则修改配置文件,并执行如下的命令使配置文件生效。(正确则忽略此步)

1 | source ~/.bashrc |

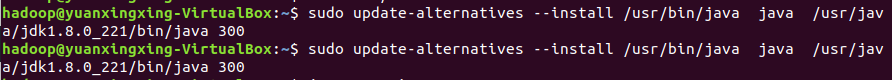

配置软连接

软连接相当于windows系统中的快捷键,部分软件可能会从/usr/bin目录下查找Java,因此添加该软连接防止其他软件查找不到的情况。

1 | sudo update-alternatives --install /usr/bin/java java /usr/java/jdk1.8.0_221/bin/java 300 |

1 | sudo update-alternatives --install /usr/bin/javac javac /usr/java/jdk1.8.0_221/bin/javac 300 |

再次尝试运行Spark自带的实例,若成功,则到此就结束,反之进行下一步。

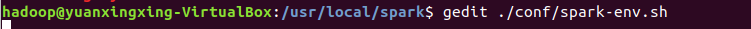

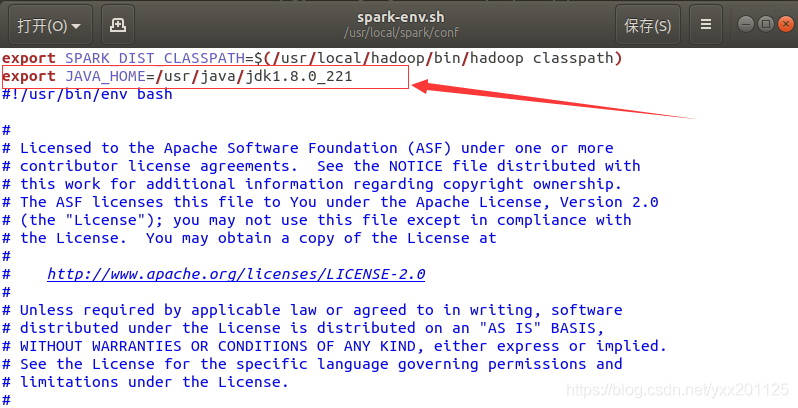

配置修改文件spark-env中export (导入)jdk的路径

jdk找不到路径问题,/usr/local/spark/conf/spark-env.sh文件中添加如下的 Java环境信息(可加到文本末尾,注意jdk版本号),直接配置修改文件spark-env中export (导入)jdk的路径即可。

1 | export JAVA_HOME=/usr/java/jdk1.8.0_221 |

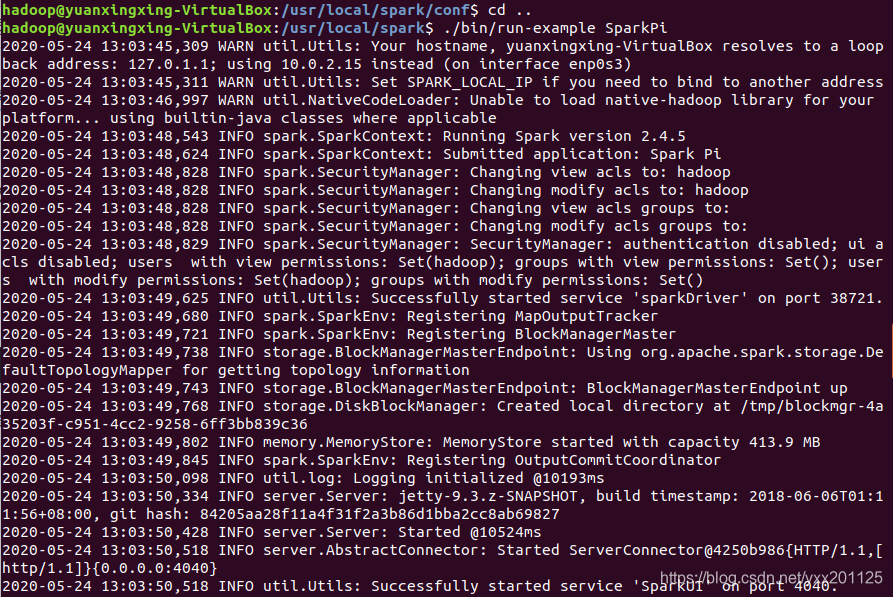

再次进行验证

1 | ./bin/run-example SparkPi |

到此,该问题就解决啦,Spark可以正常使用了